我意识到胜率在骗我的那一刻

在我数据科学职业生涯的早期,我构建了一个我认为很棒的预测模型。它在测试数据上有68%的胜率。我非常兴奋。

然后有人问了我一个简单的问题:"你的Brier分数是多少?"

我完全不知道那是什么。所以我计算了一下。结果我的"68%准确"模型实际上*比*仅使用市场共识概率*更差*。怎么会?

因为我的模型过于自信。当它应该说60%时,它说了85%。高胜率掩盖了糟糕的概率估计。

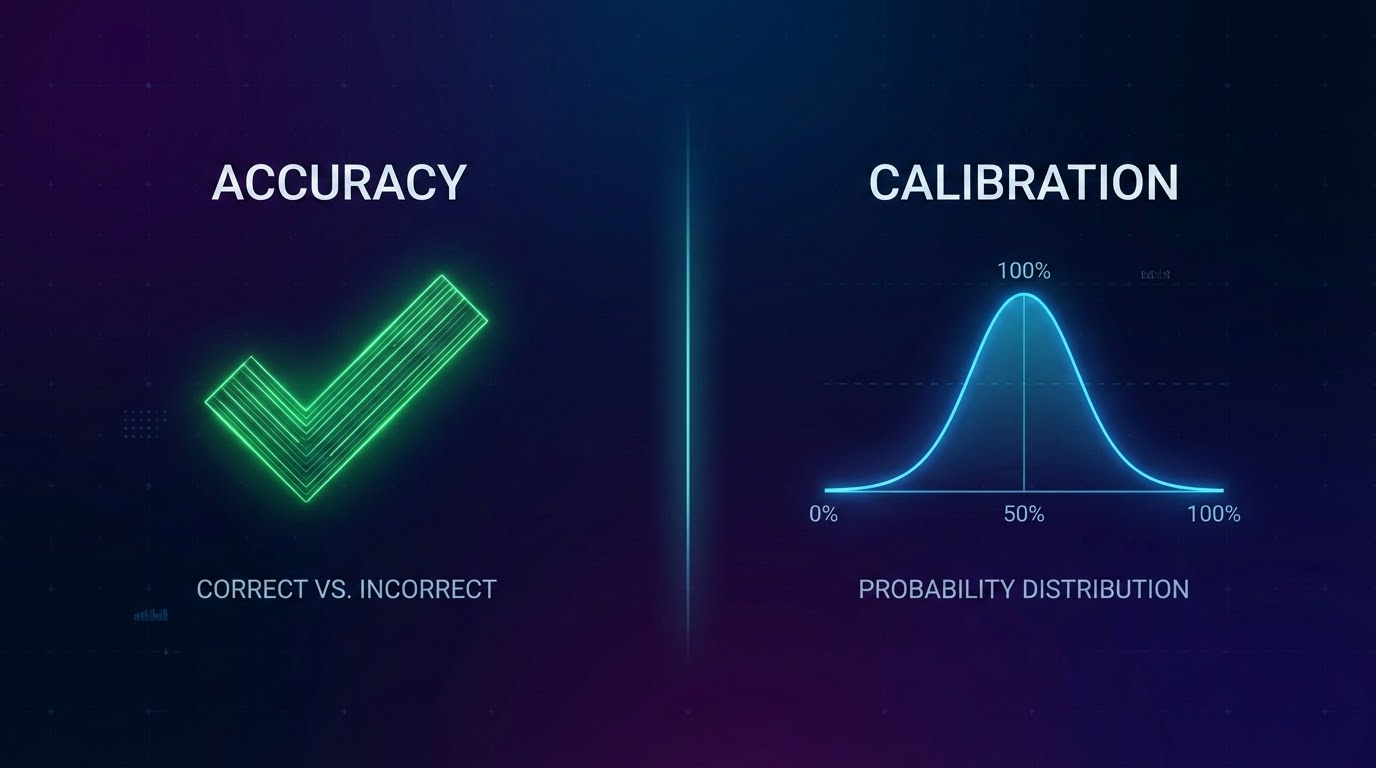

那天我学到了准确率和校准之间的区别。

校准实际上意味着什么

这是我能给出的最简单的定义:

一个经过校准的模型的60%预测应该大约60%的时间成真。

如果你对100场不同的比赛预测60%,大约应该有60场发生。不是80,不是40——大约60。

听起来很明显,对吧?但大多数模型在这个测试中表现很差。

为什么单独的胜率是危险的

胜率告诉你你的最高预测正确了多少次。但它忽略了其他一切:

问题1:信心水平

如果你预测主场胜率51%并且它发生了,那是一胜。如果你预测主场胜率90%并且它发生了,那也是一胜。同样的分数,完全不同的质量。

问题2:概率分布

一个说"每场比赛都是50/50"的模型会非常无用,即使它somehow达到了50%的准确率。

问题3:它奖励过度自信

模型学会更加极端,因为事后看起来很好。"我说了80%并且我是对的!"但你是否足够频繁地正确以证明80%?

我们实际上如何评估我们的模型

我们使用两个主要指标:

Brier分数

这衡量你预测的概率和实际发生的事情之间的平方差。如果你说70%并且发生了,你得到一个小惩罚。如果你说70%但没有发生,你得到更大的惩罚。

越低越好。完美的Brier分数是0。随机猜测得到0.25。

校准桶

我们按信心水平分组所有预测:

- 50-60%之间的所有预测

- 60-70%之间的所有预测

- 以此类推...

然后我们检查:50-60%的桶实际上是否大约55%的时间命中?70-80%的桶是否大约75%命中?

如果你的桶偏离了,你的模型就是校准不良——它在说谎它真正应该有多自信。

关键要点

- 1胜率可以隐藏过度自信、校准不良的模型

- 2校准意味着你的概率与现实匹配

- 3Brier分数衡量概率质量,而不仅仅是正确性

- 4在不同信心水平上测试你的模型校准

- 5与基线比较——打败随机是不够的

*OddsFlow提供AI驱动的体育分析,仅供教育和信息目的。*