El Momento en Que Me Di Cuenta de Que el Win Rate Me Mentía

Al principio de mi carrera en ciencia de datos, construí lo que pensé que era un gran modelo de predicción. Tenía un 68% de tasa de acierto en datos de prueba. Estaba emocionado.

Entonces alguien me hizo una pregunta simple: "¿Cuál es tu puntuación Brier?"

No tenía idea de qué era eso. Así que lo calculé. Resulta que mi modelo "68% preciso" era en realidad *peor* que simplemente usar las probabilidades de consenso del mercado. ¿Cómo?

Porque mi modelo estaba sobreconfiado. Cuando debería haber dicho 60%, decía 85%. La alta tasa de acierto ocultaba estimaciones de probabilidad terribles.

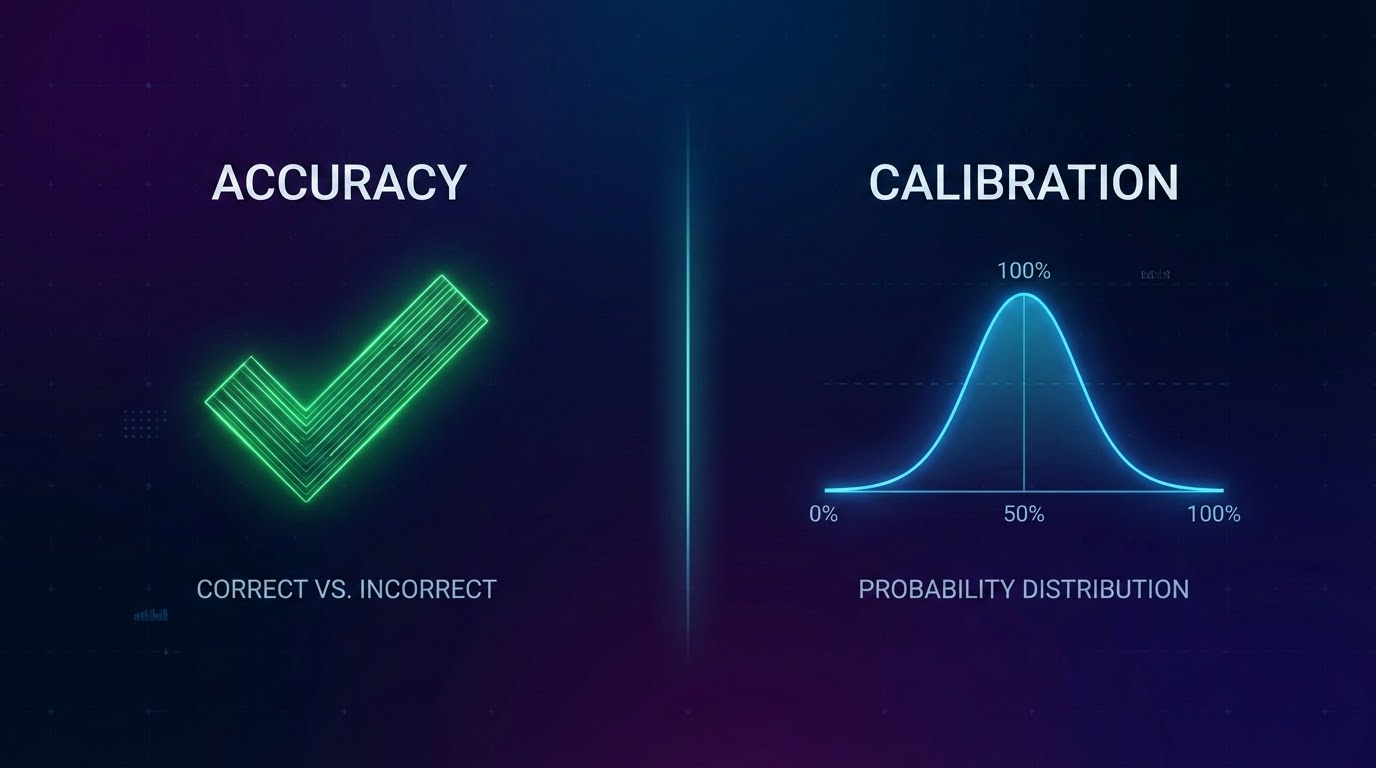

Ese día aprendí la diferencia entre precisión y calibración.

Qué Significa Realmente la Calibración

La definición más simple:

Las predicciones del 60% de un modelo calibrado deberían hacerse realidad aproximadamente el 60% de las veces.

Si predices 60% para 100 partidos diferentes, aproximadamente 60 deberían ocurrir. No 80. No 40. Alrededor de 60.

¿Suena obvio, verdad? Pero la mayoría de los modelos fallan terriblemente en esta prueba.

Por Qué el Win Rate Solo Es Peligroso

El win rate te dice con qué frecuencia tu predicción principal fue correcta. Pero ignora todo lo demás:

Problema 1: Nivel de confianza

Si predices 51% de victoria local y ocurre, es una victoria. Si predices 90% de victoria local y ocurre, también es una victoria. Mismo crédito, calidad completamente diferente.

Problema 2: Distribución de probabilidades

Un modelo que dice "cada partido es 50/50" sería terriblemente inútil.

Problema 3: Recompensa la sobreconfianza

Los modelos aprenden a ser extremos porque se ve bien después.

Cómo Realmente Evaluamos Nuestros Modelos

Puntuación Brier: Mide la diferencia al cuadrado entre la probabilidad predicha y lo que realmente ocurrió.

Buckets de calibración: Agrupamos todas las predicciones por nivel de confianza y verificamos las tasas de acierto reales.

Puntos Clave

- 1El win rate puede ocultar modelos sobreconfiados y mal calibrados

- 2Calibración significa que tus probabilidades coinciden con la realidad

- 3La puntuación Brier mide la calidad de probabilidad, no solo la corrección

- 4Prueba la calibración de tu modelo en diferentes niveles de confianza

- 5Compara con líneas base—ganarle al azar no es suficiente

📖 Lectura relacionada: Cómo Construimos Características • Backtesting Adecuado

*OddsFlow proporciona análisis deportivo impulsado por IA con fines educativos e informativos.*