O Momento em Que Percebi Que o Win Rate Estava Me Mentindo

No início da minha carreira em ciência de dados, construí o que pensei ser um ótimo modelo de previsão. Tinha 68% de taxa de acerto nos dados de teste. Eu estava empolgado.

Então alguém me fez uma pergunta simples: "Qual é o seu Brier score?"

Eu não fazia ideia do que era isso. Então calculei. Descobri que meu modelo "68% preciso" era na verdade *pior* do que simplesmente usar as probabilidades de consenso do mercado. Como?

Porque meu modelo estava superconfiante. Quando deveria dizer 60%, dizia 85%. A alta taxa de acerto escondia estimativas de probabilidade terríveis.

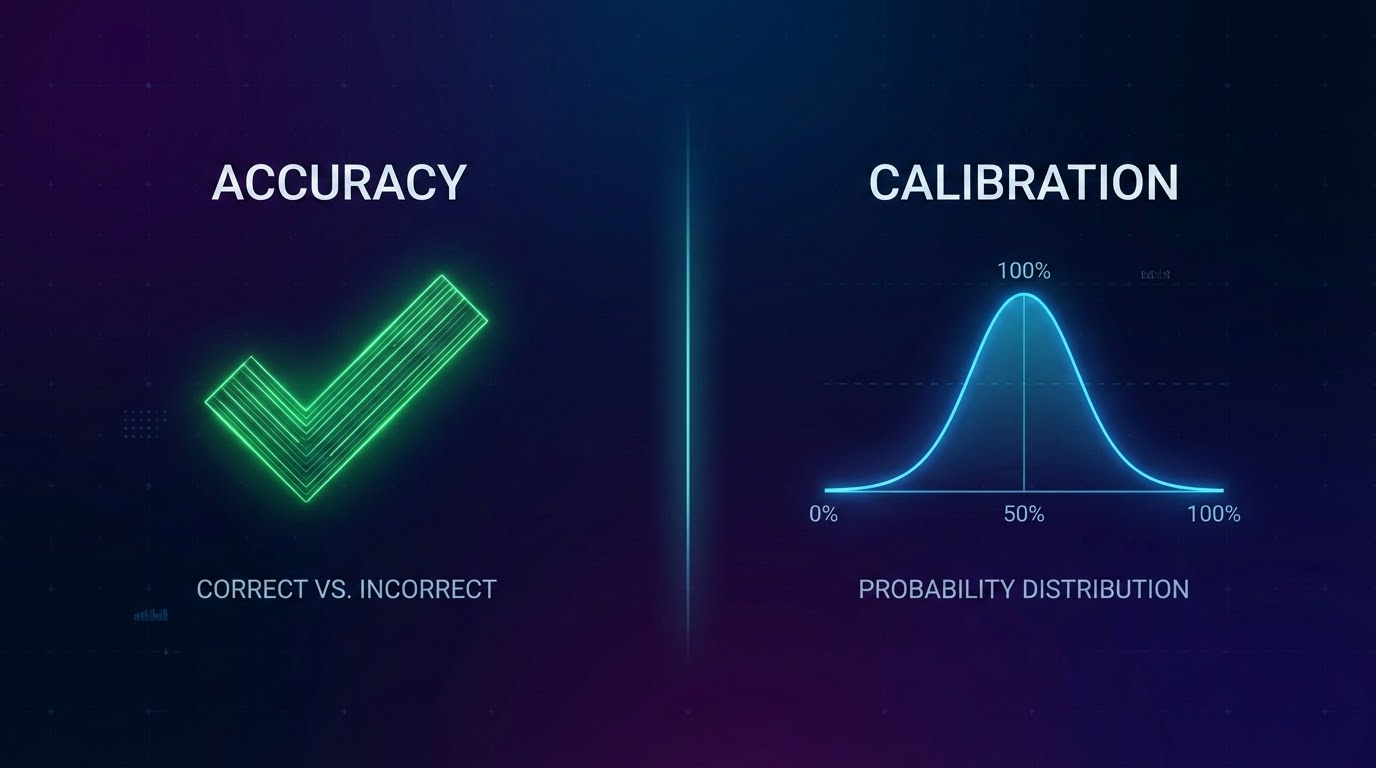

Naquele dia aprendi a diferença entre precisão e calibração.

O Que Calibração Realmente Significa

A definição mais simples:

As previsões de 60% de um modelo calibrado devem se tornar realidade aproximadamente 60% das vezes.

Se você prevê 60% para 100 partidas diferentes, aproximadamente 60 devem acontecer. Não 80. Não 40. Cerca de 60.

Parece óbvio, certo? Mas a maioria dos modelos falha terrivelmente neste teste.

Por Que o Win Rate Sozinho É Perigoso

O win rate te diz com que frequência sua principal previsão estava correta. Mas ignora todo o resto:

Problema 1: Nível de confiança

Se você prevê 51% de vitória em casa e acontece, é uma vitória. Se você prevê 90% de vitória em casa e acontece, também é uma vitória. Mesmo crédito, qualidade completamente diferente.

Problema 2: Distribuição de probabilidades

Um modelo que diz "toda partida é 50/50" seria terrivelmente inútil.

Problema 3: Recompensa superconfiança

Modelos aprendem a ser extremos porque parece bom depois.

Como Realmente Avaliamos Nossos Modelos

Brier Score: Mede a diferença quadrada entre a probabilidade prevista e o que realmente aconteceu.

Buckets de calibração: Agrupamos todas as previsões por nível de confiança e verificamos as taxas de acerto reais.

Pontos-Chave

- 1Win rate pode esconder modelos superconfiantes e mal calibrados

- 2Calibração significa que suas probabilidades correspondem à realidade

- 3Brier score mede qualidade de probabilidade, não apenas correção

- 4Teste a calibração do seu modelo em diferentes níveis de confiança

- 5Compare com baselines—vencer o aleatório não é suficiente

📖 Leitura relacionada: Como Construímos Features • Backtesting Adequado

*OddsFlow fornece análise esportiva alimentada por IA para fins educacionais e informativos.*