승률이 나에게 거짓말하고 있다는 것을 깨달은 순간

데이터 과학 경력 초기에, 저는 훌륭하다고 생각한 예측 모델을 만들었습니다. 테스트 데이터에서 68%의 승률을 보였습니다. 저는 흥분했습니다.

그런데 누군가 간단한 질문을 했습니다: "Brier 점수가 뭐죠?"

저는 그게 뭔지 전혀 몰랐습니다. 그래서 계산해 봤습니다. 제 "68% 정확한" 모델이 실제로 시장 컨센서스 확률만 사용하는 것보다 *나쁘다*는 것이 밝혀졌습니다. 어떻게?

제 모델이 과신했기 때문입니다. 60%라고 해야 할 때 85%라고 했습니다. 높은 승률이 형편없는 확률 추정을 숨기고 있었습니다.

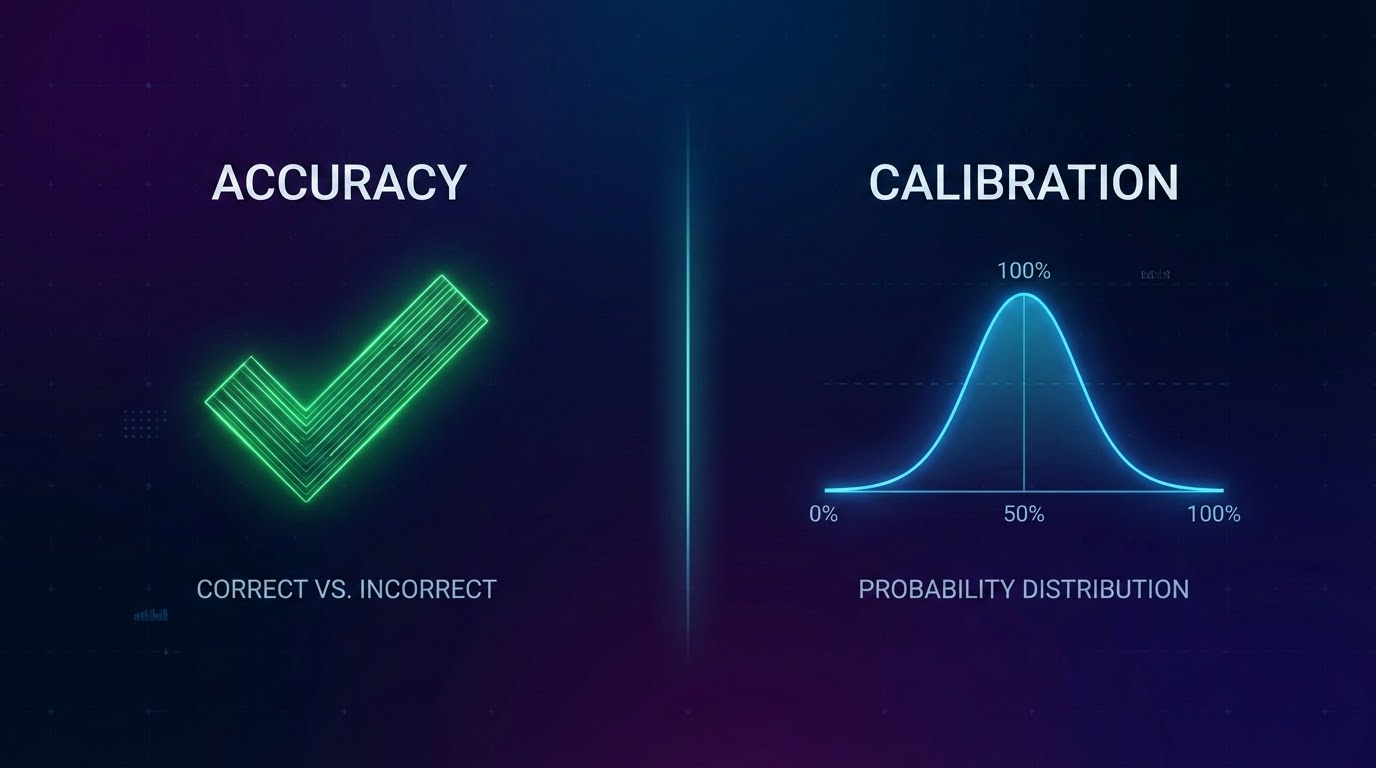

그날 저는 정확도와 보정의 차이를 배웠습니다.

보정이 실제로 의미하는 것

가장 간단한 정의:

보정된 모델의 60% 예측은 약 60%의 확률로 실현되어야 합니다.

100개의 다른 경기에 60%를 예측하면, 약 60개가 발생해야 합니다. 80이 아니라. 40이 아니라. 약 60.

당연해 보이죠? 하지만 대부분의 모델은 이 테스트에서 끔찍하게 실패합니다.

승률만으로는 위험한 이유

승률은 최고 예측이 얼마나 자주 맞았는지를 알려줍니다. 하지만 나머지는 모두 무시합니다:

문제 1: 신뢰 수준

51%로 홈 승리를 예측하고 그것이 일어나면, 그것은 승리입니다. 90%로 홈 승리를 예측하고 그것이 일어나면, 그것도 승리입니다. 같은 점수, 완전히 다른 품질.

문제 2: 확률 분포

"모든 경기가 50/50"이라고 말하는 모델은 끔찍하게 쓸모없을 것입니다.

문제 3: 과신을 보상

모델은 극단적이 되는 법을 배웁니다. 나중에 좋아 보이기 때문입니다.

실제로 모델을 어떻게 평가하는가

Brier 점수: 예측 확률과 실제로 일어난 것 사이의 제곱 차이를 측정합니다.

보정 버킷: 모든 예측을 신뢰 수준별로 그룹화하고 실제 적중률을 확인합니다.

핵심 포인트

- 1승률은 과신하고 보정이 나쁜 모델을 숨길 수 있음

- 2보정은 확률이 현실과 일치한다는 의미

- 3Brier 점수는 정확성만이 아닌 확률 품질을 측정

- 4다양한 신뢰 수준에서 모델 보정을 테스트

- 5기준선과 비교—무작위를 이기는 것만으로는 충분하지 않음

*OddsFlow는 교육 및 정보 제공 목적으로 AI 기반 스포츠 분석을 제공합니다.*