勝率が私に嘘をついていることに気づいた瞬間

データサイエンスのキャリアの初期に、私は素晴らしいと思った予測モデルを構築しました。テストデータで68%の勝率でした。私は興奮しました。

そして誰かが簡単な質問をしました:「あなたのブライアスコアは?」

私はそれが何か全く分かりませんでした。計算してみると、私の「68%正確」なモデルは、実際には市場コンセンサス確率を使うだけより*悪い*ことが分かりました。どうして?

モデルが過信していたからです。60%と言うべきときに85%と言っていました。高い勝率は、ひどい確率推定を隠していました。

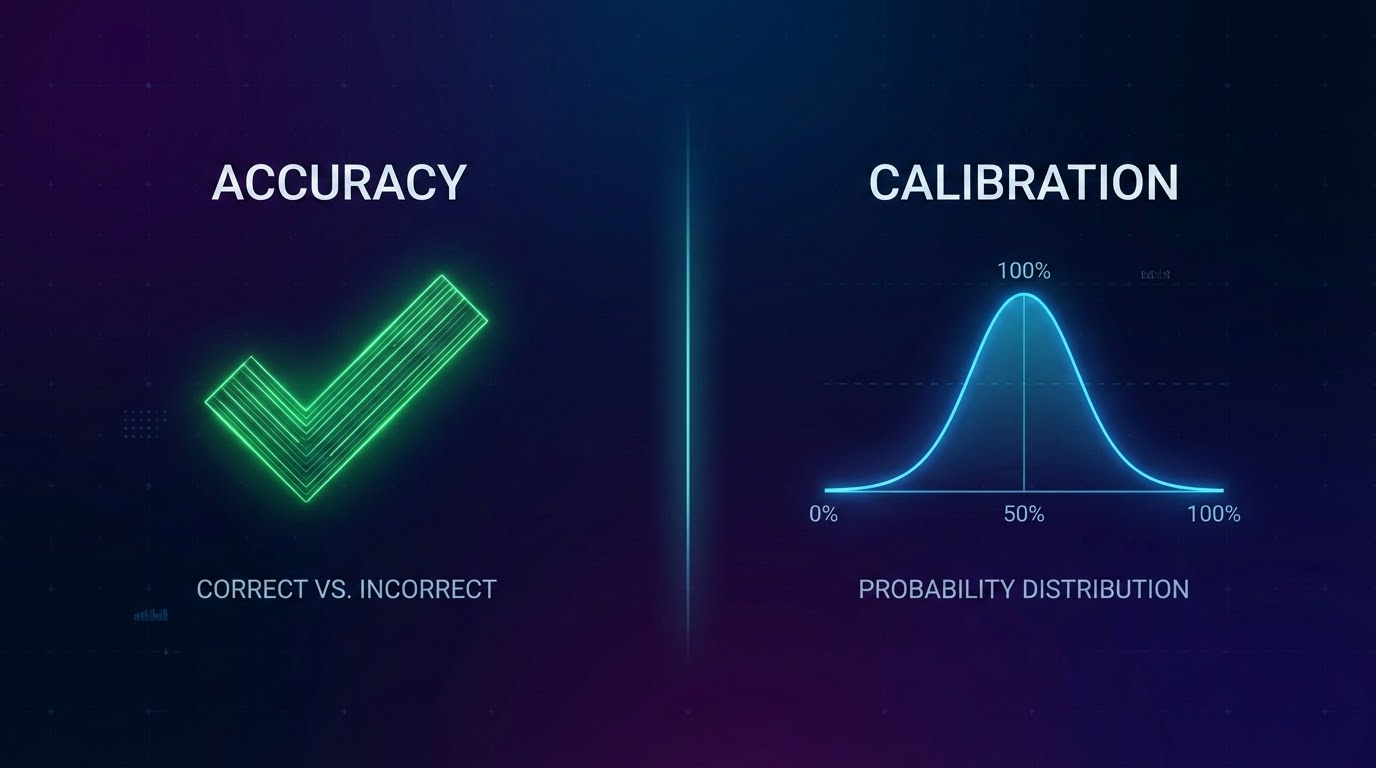

その日、精度とキャリブレーションの違いを学びました。

キャリブレーションの実際の意味

最も簡単な定義:

キャリブレーションされたモデルの60%予測は、約60%の確率で実現するべきです。

100の異なる試合に60%を予測した場合、約60が起こるべきです。80でも40でもなく、約60。

当たり前のように聞こえますよね?しかし、ほとんどのモデルはこのテストにひどく失敗します。

なぜ勝率だけでは危険なのか

勝率は、トップ予測が正しかった頻度を教えてくれます。しかし、他のすべてを無視します:

問題1:信頼レベル

51%でホーム勝利を予測してそれが起こったら、それは勝ちです。90%でホーム勝利を予測してそれが起こったら、それも勝ちです。同じクレジット、完全に異なる品質。

問題2:確率分布

「すべての試合は50/50」と言うモデルは、たとえ何らかの形で50%の精度を達成しても、ひどく役に立たないでしょう。

問題3:過信を報酬する

モデルは極端になることを学習します。「80%と言って正しかった!」しかし、80%を正当化するほど頻繁に正しかったですか?

実際にモデルをどう評価するか

ブライアスコア:予測確率と実際に起こったことの二乗差を測定します。

キャリブレーションバケット:すべての予測を信頼レベルでグループ化し、実際のヒット率をチェックします。

重要なポイント

- 1勝率は過信して、キャリブレーションが不十分なモデルを隠すことができる

- 2キャリブレーションとは、確率が現実と一致すること

- 3ブライアスコアは、正確さだけでなく確率の品質を測定

- 4異なる信頼レベルでモデルのキャリブレーションをテスト

- 5ベースラインと比較——ランダムに勝つだけでは不十分

*OddsFlowは教育および情報目的でAI駆動のスポーツ分析を提供しています。*