Le Moment Où J'ai Réalisé Que le Win Rate Me Mentait

Au début de ma carrière en science des données, j'ai construit ce que je pensais être un excellent modèle de prédiction. Il avait un taux de réussite de 68% sur les données de test. J'étais ravi.

Puis quelqu'un m'a posé une question simple: "Quel est votre score Brier?"

Je n'avais aucune idée de ce que c'était. Alors je l'ai calculé. Il s'avère que mon modèle "précis à 68%" était en fait *pire* que simplement utiliser les probabilités de consensus du marché. Comment?

Parce que mon modèle était surconfiant. Quand il aurait dû dire 60%, il disait 85%. Le taux de réussite élevé cachait de terribles estimations de probabilité.

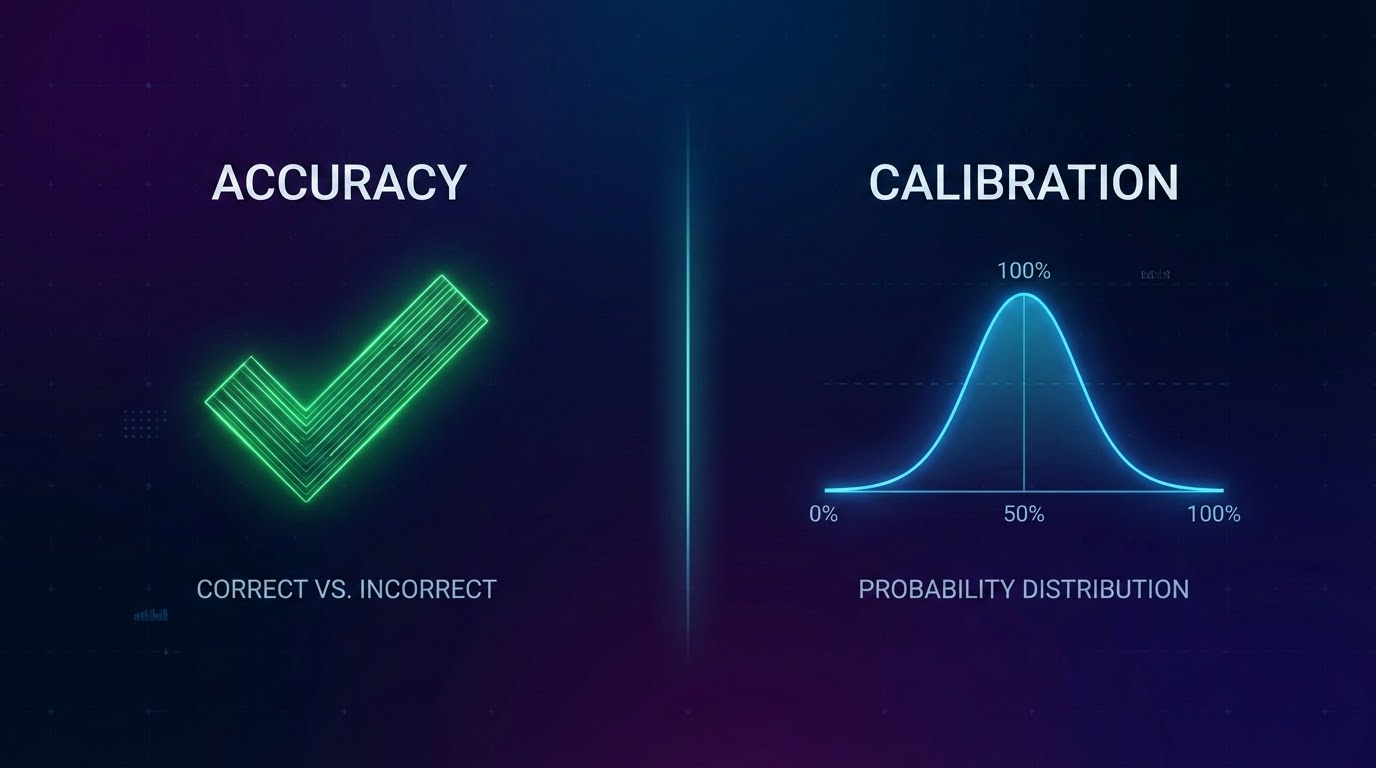

Ce jour-là, j'ai appris la différence entre précision et calibration.

Ce Que Signifie Vraiment la Calibration

La définition la plus simple:

Les prédictions à 60% d'un modèle calibré devraient se réaliser environ 60% du temps.

Si vous prédisez 60% pour 100 matchs différents, environ 60 devraient se produire. Pas 80. Pas 40. Environ 60.

Ça semble évident, non? Mais la plupart des modèles échouent lamentablement à ce test.

Pourquoi le Win Rate Seul Est Dangereux

Le win rate vous dit à quelle fréquence votre prédiction principale était correcte. Mais il ignore tout le reste:

Problème 1: Niveau de confiance

Si vous prédisez 51% de victoire à domicile et ça arrive, c'est une victoire. Si vous prédisez 90% de victoire à domicile et ça arrive, c'est aussi une victoire. Même crédit, qualité complètement différente.

Problème 2: Distribution des probabilités

Un modèle qui dit "chaque match est 50/50" serait terriblement inutile.

Problème 3: Il récompense la surconfiance

Les modèles apprennent à être extrêmes parce que ça semble bien après coup.

Comment Nous Évaluons Réellement Nos Modèles

Score Brier: Mesure la différence au carré entre la probabilité prédite et ce qui s'est réellement passé.

Seaux de calibration: Nous groupons toutes les prédictions par niveau de confiance et vérifions les taux de réussite réels.

Points Clés

- 1Le win rate peut cacher des modèles surconfiants et mal calibrés

- 2La calibration signifie que vos probabilités correspondent à la réalité

- 3Le score Brier mesure la qualité de probabilité, pas seulement la correction

- 4Testez la calibration de votre modèle à différents niveaux de confiance

- 5Comparez aux baselines—battre le hasard ne suffit pas

📖 Lecture connexe: Comment Nous Construisons les Caractéristiques • Backtesting Correct

*OddsFlow fournit des analyses sportives alimentées par l'IA à des fins éducatives et informatives.*