Der Moment, Als Mir Klar Wurde, Dass Die Gewinnrate Mich Anlog

Früh in meiner Datenwissenschafts-Karriere baute ich ein Vorhersagemodell, von dem ich dachte, es sei großartig. Es hatte eine Gewinnrate von 68% auf Testdaten. Ich war begeistert.

Dann stellte mir jemand eine einfache Frage: "Was ist Ihr Brier-Score?"

Ich hatte keine Ahnung, was das war. Also berechnete ich es. Es stellte sich heraus, dass mein "68% genaues" Modell tatsächlich *schlechter* war als nur die Markt-Konsens-Wahrscheinlichkeiten zu verwenden. Wie?

Weil mein Modell überkonfidenzt war. Wenn es 60% hätte sagen sollen, sagte es 85%. Die hohe Gewinnrate verbarg schreckliche Wahrscheinlichkeitsschätzungen.

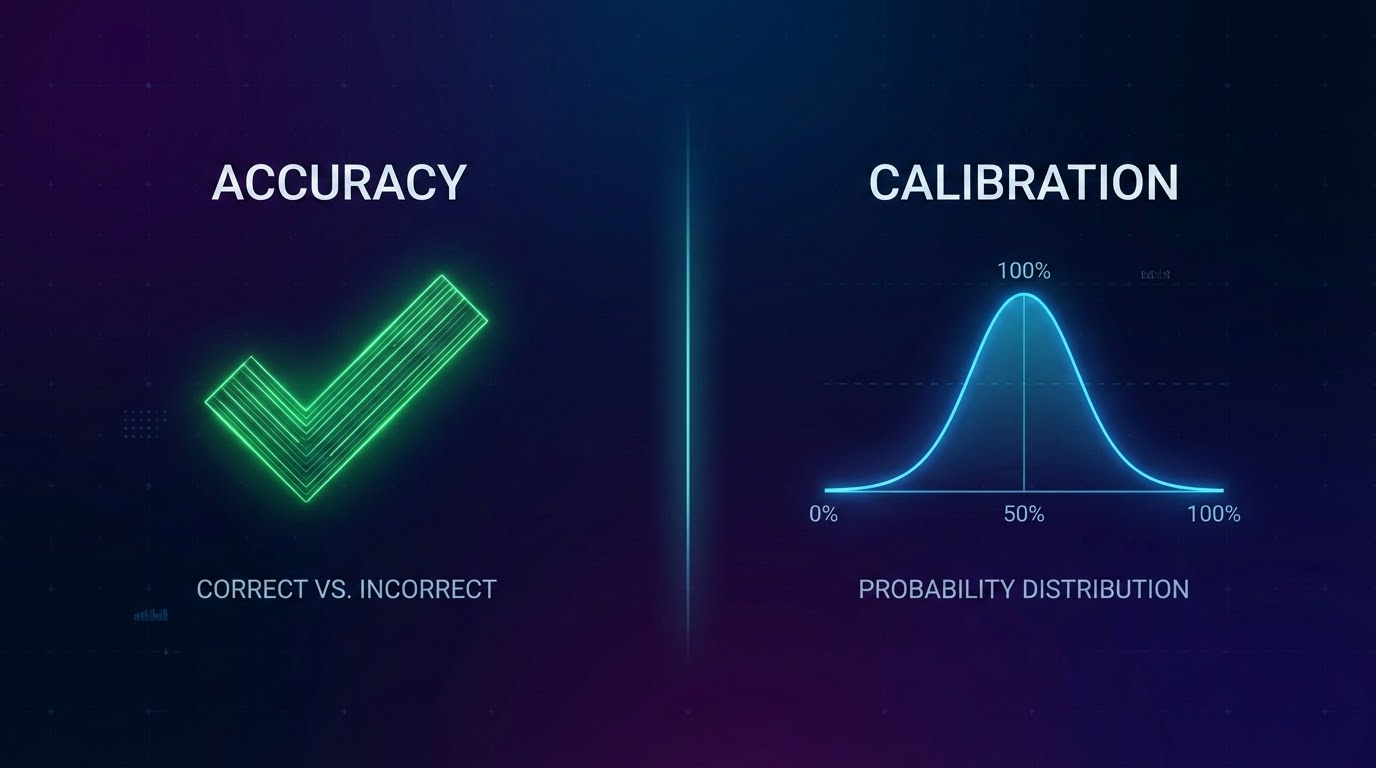

An diesem Tag lernte ich den Unterschied zwischen Genauigkeit und Kalibrierung.

Was Kalibrierung Wirklich Bedeutet

Die einfachste Definition:

Die 60%-Vorhersagen eines kalibrierten Modells sollten etwa 60% der Zeit wahr werden.

Wenn Sie 60% für 100 verschiedene Spiele vorhersagen, sollten etwa 60 eintreten. Nicht 80. Nicht 40. Etwa 60.

Klingt offensichtlich, oder? Aber die meisten Modelle scheitern bei diesem Test schrecklich.

Warum Gewinnrate Allein Gefährlich Ist

Gewinnrate sagt Ihnen, wie oft Ihre Top-Vorhersage richtig war. Aber es ignoriert alles andere:

Problem 1: Konfidenz-Level

Wenn Sie 51% Heimsieg vorhersagen und es passiert, ist das ein Gewinn. Wenn Sie 90% Heimsieg vorhersagen und es passiert, ist das auch ein Gewinn. Gleiche Anerkennung, völlig unterschiedliche Qualität.

Problem 2: Wahrscheinlichkeitsverteilung

Ein Modell, das sagt "jedes Spiel ist 50/50", wäre schrecklich nutzlos.

Problem 3: Es belohnt Überkonfidenz

Modelle lernen, extrem zu sein, weil es im Nachhinein gut aussieht.

Wie Wir Unsere Modelle Tatsächlich Bewerten

Brier-Score: Misst den quadrierten Unterschied zwischen vorhergesagter Wahrscheinlichkeit und dem, was tatsächlich passiert ist.

Kalibrierungs-Buckets: Wir gruppieren alle Vorhersagen nach Konfidenz-Level und prüfen die tatsächlichen Trefferquoten.

Wichtige Erkenntnisse

- 1Gewinnrate kann überkonfidenzte, schlecht kalibrierte Modelle verbergen

- 2Kalibrierung bedeutet, dass Ihre Wahrscheinlichkeiten mit der Realität übereinstimmen

- 3Brier-Score misst Wahrscheinlichkeitsqualität, nicht nur Korrektheit

- 4Testen Sie die Kalibrierung Ihres Modells auf verschiedenen Konfidenz-Levels

- 5Vergleichen Sie mit Baselines—Zufall zu schlagen reicht nicht

📖 Weiterführende Lektüre: Wie Wir Features Bauen • Korrektes Backtesting

*OddsFlow bietet KI-gestützte Sportanalysen für Bildungs- und Informationszwecke.*